学习

装饰器模式

智能合约

矩阵

分子对接

tcp

labview

命令行

费用最优

C/C++

后断开发

web前端期末大作业

虚拟主机

433MHz自发电无线控制器

plugin

uart串口通信

汇编求解一元二次方程的解

addWaiter

断裂力学

安杰思

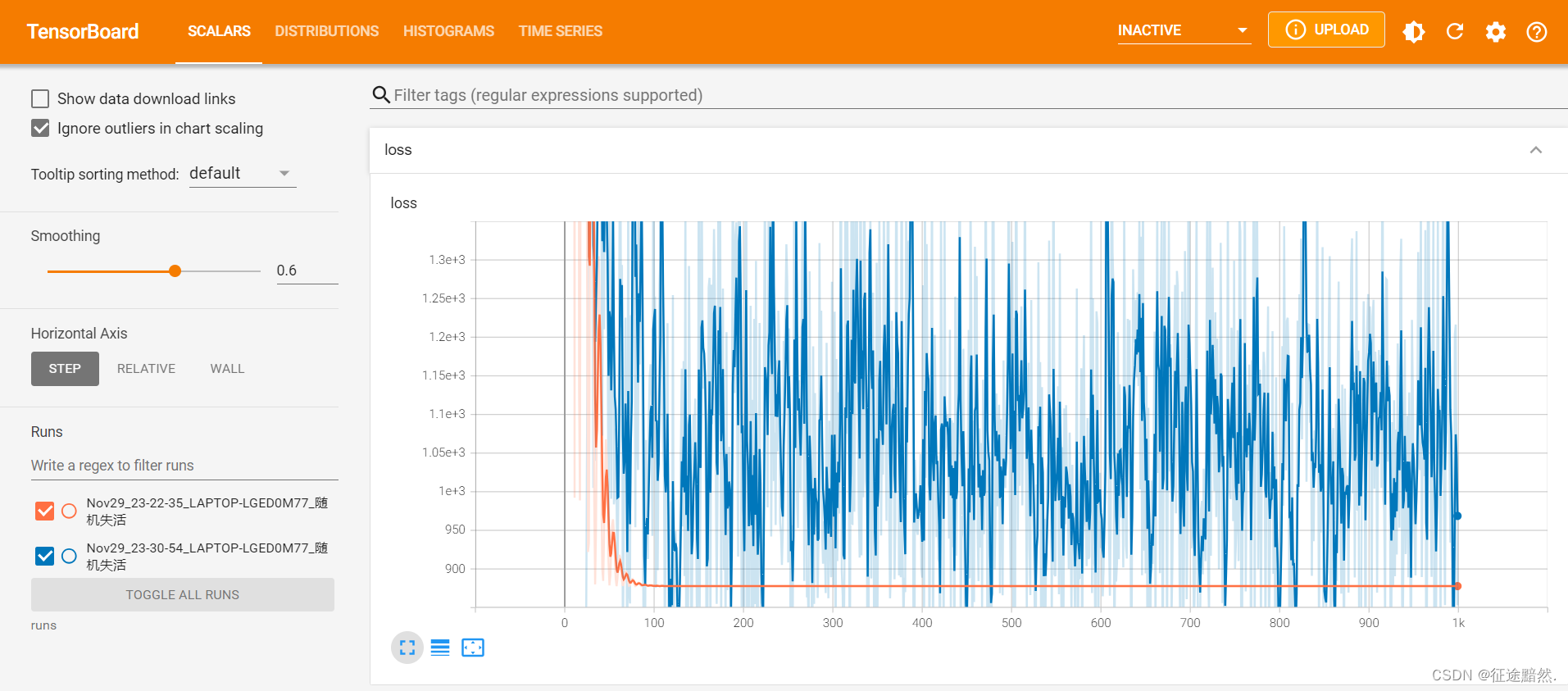

Dropout

2024/4/16 8:06:46XGB-5: DART Booster

XGBoost 主要结合了大量的回归树和一个小的学习率。在这种情况下,早期添加的树是重要的,而晚期添加的树是不重要的。

Vinayak 和 Gilad-Bachrach 提出了一种将深度神经网络社区的 dropout 技术应用于梯度提升树的新方法,并在某些情况下报告了…

政安晨:【深度学习实践】【使用 TensorFlow 和 Keras 为结构化数据构建和训练神经网络】(五)—— Dropout和批归一化

政安晨的个人主页:政安晨 欢迎 👍点赞✍评论⭐收藏 收录专栏: TensorFlow与Keras实战演绎 希望政安晨的博客能够对您有所裨益,如有不足之处,欢迎在评论区提出指正! Dropout和批归一化是深度学习领域中常用的正则化技术…

dropout层加在哪里

Dropout层通常用于深度学习模型中,以防止过拟合。它在神经网络中的位置可以有一些不同的选择,但通常是在全连接层之间或卷积层之间添加的。这有助于随机地关闭一些神经元,从而减少它们对模型的训练影响,以增强模型的泛化能力。 以…

深度学习基础入门篇[六(1)]:模型调优:注意力机制[多头注意力、自注意力],正则化【L1、L2,Dropout,Drop Connect】等

【深度学习入门到进阶】必看系列,含激活函数、优化策略、损失函数、模型调优、归一化算法、卷积模型、序列模型、预训练模型、对抗神经网络等 专栏详细介绍:【深度学习入门到进阶】必看系列,含激活函数、优化策略、损失函数、模型调优、归一化…

CNN层调参经验与Drop层、BN层的使用经验

转载地址:https://www.cnblogs.com/bonelee/p/8534560.html

https://blog.csdn.net/sean2100/article/details/83834565 两篇文章主要给了两个结论:

结论一:CNN 文本分类模型优化经验——关键点:加卷积层和FC可以提高精度&#…

深度学习中的Dropout

1 Dropout概述

1.1 什么是Dropout

在2012年,Hinton在其论文《Improving neural networks by preventing co-adaptation of feature detectors》中提出Dropout。当一个复杂的前馈神经网络被训练在小的数据集时,容易造成过拟合。为了防止过拟合ÿ…

抑制过拟合——Dropout原理

抑制过拟合——Dropout原理 Dropout的工作原理 实验观察 在机器学习领域,尤其是当我们处理复杂的模型和有限的训练样本时,一个常见的问题是过拟合。简而言之,过拟合发生在模型对训练数据学得太好,以至于它捕捉到了数据中的噪声和…

Dropout原理,代码浅析

Dropout原理介绍 一:引言

因为在机器学习的一些模型中,如果模型的参数太多,而训练样本又太少的话,这样训练出来的模型很容易产生过拟合现象。在训练bp网络时经常遇到的一个问题,过拟合指的是模型在训练数据上损失函数…

Keras - Dropout 理论与实践

一.引言 Dropout 层用于解决过拟合的问题,当原始样本偏少而深度模型参数偏多时,模型偏向于学习一些极端的特征从而导致过拟合,在训练样本上达到很高的精度但在测试集的表现却很糟糕,这时候可以引入 Dropout 按适当的比例舍弃掉一些…

KL Divergence ——衡量两个概率分布之间的差异

文章目录1 什么是KL Divergence(KL散度,也说是KL距离)2 一个简单的例子3 KL的性质4 KL散度的公式介绍5 Pytorch实现KL散度——F.kl_div()5.1 函数原型5.2 简单代码6 KL散度在R- Drop中的应用6.1 什么是Dropout?6.2 引入 R-drop6.3 在R-Drop的…

![深度学习基础入门篇[六(1)]:模型调优:注意力机制[多头注意力、自注意力],正则化【L1、L2,Dropout,Drop Connect】等](https://img-blog.csdnimg.cn/img_convert/aa43037280f3646179c75764402f12b3.png)